CoreWeave 借助 NVIDIA BlueField DPU 开创数据中心新范式,实现数据中心的革命性变革

AI 变革正在重塑数据中心格局,亟需能够提供更灵活、高性价比的计算和数据能力的平台。为了满足这些需求,作为推动 AI 变革的超大规模云服务提供商,CoreWeave 致力于开发一种用于加速计算工作负载的云平台,该云平台能够在多租户环境中提供高性能、严格的租户隔离和安全性。

CoreWeave 云平台使用 NVIDIA® BlueField® DPU,简化了大规模先进基础设施的工程、组装、运行和监测,为 AI 工作负载提供顶尖的性能与效率。

挑战

为了满足 AI 的需求,数据中心需要具有灵活、高性能、高性价比的计算与数据能力的平台。CoreWeave 致力于开发一个云规模的加速计算基础设施,以便在多租户环境中提供高性能、严格的租户隔离和安全性。

CoreWeave 的基础设施需要支持外部网络访问和内部网络计算,还必须能够管理数十万颗 NVIDIA GPU 之间的网络流量,并在高负载下保持性能。此外,该基础设施还需要卸载并加速网络和存储任务,以释放 CPU 资源,从而使处理器能够专注于处理计算密集型工作负载,并加快存储访问速度,从而实现更高效的AI计算。CoreWeave 的另一个主要目标是开发一个能够满足 AI 应用日益增长需求的基础设施,并确保其可扩展性,以便在未来更好的处理日益复杂的计算密集型大规模工作负载。CoreWeave 借助NVIDIA BlueField 网络平台和 NVIDIA DOCA 软件框架的强大功能来满足这些需求。

解决方案

借助 BlueField DPU 和 DOCA

增强网络功能

CoreWeave 使用NVIDIA DOCA 软件框架中的组件—特别是基于 OVS-DOCA 和DOCA FLOW 的 DOCA基 于主机的网络(DOCA HBN)服务,加速了云网络服务和 API。DOCA HBN 利用与 NVIDIA Cumulus Linux 网络操作系统相同的核心组件,如 FRRouting 和 NVIDIA User Experience(NVUE),并将它们打包到在 BlueField DPU 上运行的容器中。此设置使 CoreWeave 能够以可扩展、分布式的方式管理复杂的网络功能,支持多租户环境中的租户隔离、负载均衡和流量引导。这确保每个云租户只能访问自己的数据和计算任务,并确保这些任务在不影响性能的情况下得到高效管理,从而实现可扩展且安全的网络。通过卸载和加速这些任务,DOCA HBN 减轻了 CPU 负载,使其能够处理计算密集型进程,并提高整体系统性能。

借助 DOCA HBN,CoreWeave 将网络隔离功能迁移至BlueField DPU,并采用 EVPN VXLAN 为每个租户创建了独立的虚拟网络,通过 VXLAN 网络标识符处理路由流量,以确保实现完全隔离。由于严格的网络隔离对于安全性与合规性在多租户环境中至关重要。CoreWeave 还通过在 BlueField 上部署互联网网关实现了去中心化架构,并使用 OVS-DOCA 进行流量引导和网络地址转换(NAT)。BlueField 还通过托管网关和 BGP 路由,在网络流量管理方面发挥至关重要的作用,从而实现高效的网络管理。

通过 BlueField 集成实现系统级优化

为了构建下一代 AI 存储服务,即 CoreWeave AI 对象存储,CoreWeave 与 VAST Data 合作,充分利用双方与 NVIDIA 技术的深度集成。VAST 将 BlueField DPU 作为控制数据节点(DNode),通过 NVIDIA DOCA API 将数据服务直接卸载到 BlueField DPU,从而消除了对传统 x86 CPU 的需求。

该架构重新定义了数据层的控制和策略执行方式,更加接近数据流向且效率更高。CoreWeave 最初使用的 NVIDIA DPU 是 BlueField-1,现已发展至 BlueField-3,并持续致力于将 BlueField 部署到计算相邻节点(CNode)。这实现了基础设施级的多租户,其中每个 CoreWeave AI 对象存储租户都能在一个隔离且安全的网络域中运行。实时遥测和细粒度策略执行直接在 DPU 层完成。该平台对多协议访问的支持进一步简化了复杂性,并实现了跨不同计算和数据环境的无缝互操作性。

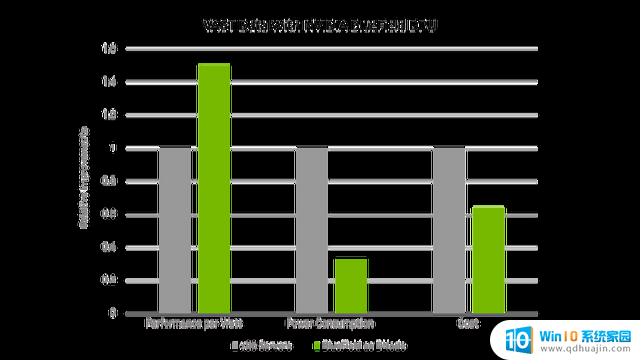

这种灵活性使 CoreWeave 能够在不影响性能或牺牲租户隔离性的情况下扩展 AI 对象存储。将控制服务卸载到 BlueField DPU 彻底重塑了基础设施的经济学,因其优化了性能、安全性和可扩展性。性能基准测试显示了该架构演进的优点:与基于 x86 架构、配备 DRAM 和传统 NVIDIA ConnectX® 网卡的 DNode 相比,基于 BlueField 的 DNode 在连续吞吐量方面提高了 60%,从 40GB/s 增加至 64GB/s,同时功耗降低了 58%,从 1200 W 下降至 500 W。这相当于每瓦性能提高了 3.84 倍。该设计为现代 AI 基础设施提供了蓝图,展示了基础设施层的软硬件协同设计如何为 CoreWeave 等云服务提供商带来效率、可扩展性和性能的巨大提升。

新系统还通过采用四块 BlueField DPU 和八个 100GbE 端口,将线路带宽提高至原来的两倍。虽然部分功耗节省归因于采用了更大、更高效的固态硬盘(SSD),但其整体效率提升主要归功于 DPU 的集成。此次测试展现了 BlueField DPU 变革数据中心架构的潜力,为像 CoreWeave 这样寻求提升 AI 基础设施性能和能效的公司提供了梦寐以求的解决方案。

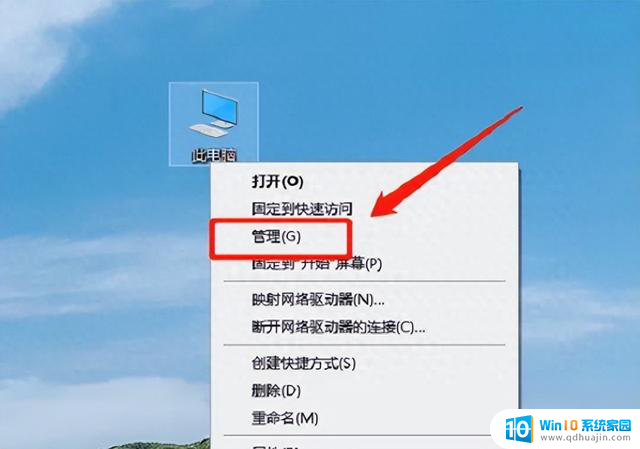

x86 CPU 与 BlueField DPU 的对比

上图通过对比,显示出运行在 x86 CPU 和运行在 NVIDIA BlueField DPU 之间的差异。

借助 NVIDIA Spectrum 以太网交换机和 Cumulus Linux 实现云规模效率

除了利用 BlueField DPU 来卸载、加速和隔离工作负载外,CoreWeave 还通过运行 NVIDIA Cumulus Linux 的 NVIDIA Spectrum 以太网交换机来连接存储和管理基础设施。Cumulus Linux 旨在通过软件驱动的自动化来简化网络管理。通过将纯三层 EVPN VXLAN 与 NVUE 对象模型的 API 相结合,CoreWeave 即使在大规模情况下也能轻松管理网络的自动化、运营和更新。

利用 NVIDIA Quantum-2 InfiniBand

实现极高的 AI 性能

CoreWeave 利用 BlueField DPU 和 Spectrum 以太网交换机构建存储与管理网络,同时使用 NVIDIA Quantum-2 InfiniBand 网络平台构建 GPU 到 GPU 的 AI 计算网络。InfiniBand 是 AI 网络的黄金标准,可为高负载和大规模 AI 训练工作负载提供极高的有效带宽和超低的延迟。InfiniBand 的功能,如动态路由和基于遥测的拥塞控制,对于多租户 AI 云环境至关重要,能够实现性能隔离,并确保所有 CoreWeave 用户都能获得所需的全部网络带宽。CoreWeave 还使用 Quantum InfiniBand 的 NVIDIA 可扩展分层聚合和归约协议(SHARP)™进行 AI 集合操作网络计算,卸载 GPU 的通信操作,简化网络流量模式,并加快任务完成时间。

总结

CoreWeave 使用 NVIDIA DOCA 部署 NVIDIA BlueField DPU,从而变革了其 AI 云基础设施,并在技术、运营和业务层面带来了显著的价值。通过集成 BlueField DPU,CoreWeave 构建出一个高效、可扩展、安全的平台,满足了现代 AI 工作负载和云端运营的严苛要求。凭借将 VAST Data 的存储解决方案与NVIDIA BlueField DPU相结合这一创新方法,CoreWeave 已跻身领先的 AI 云服务提供商之列,并通过对创新技术的不懈追求来满足未来的客户需求,同时应对日益复杂的 AI 工作负载。

战略性的部署 NVIDIA BlueField DPU 和 NVIDIA DOCA 软件框架等先进技术,可以彻底改变 AI 应用的云基础设施。CoreWeave 成功利用 BlueField DPU 构建了可扩展、高效且安全的 AI 云平台,彰显了 BlueField DPU 在优化 AI 和高性能计算基础设施方面的显著优势。