NVIDIA Blackwell 平台:水效率提升超 300 倍,散热新突破!

传统上,数据中心依赖风冷,也就是通过冷水机组循环输送冷空气来吸收服务器所产生的热量,以使服务器保持最佳运行状态。但随着 AI 模型的规模增加以及 AI 推理模型使用越来越广泛,保持最佳运行状态不仅面临更多困难、成本更昂贵,而且能耗也更大。

在数据中心内,每个机架的功率曾经只有 20 千瓦,而在如今的超大规模设施内,每个机架的功率超过 135 千瓦。在这种情况下,高密度机架散热的难度增加了一个量级。为了让 AI 服务器保持峰值性能,就需要一种全新的散热方法来提高能效和可扩展性。

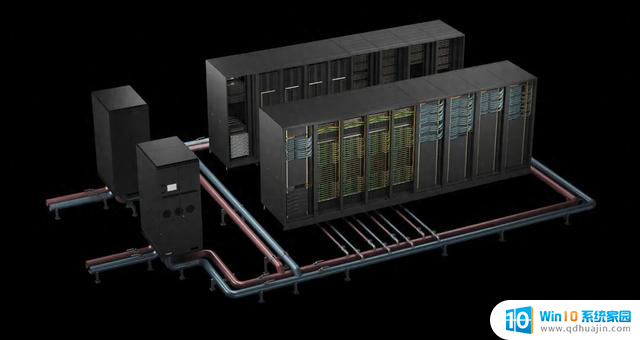

液冷技术是其中一个关键解决方案。通过减少对冷水机组的依赖并实现更高效的散热,液冷技术正推动下一代高性能、高能效 AI 基础设施的发展。

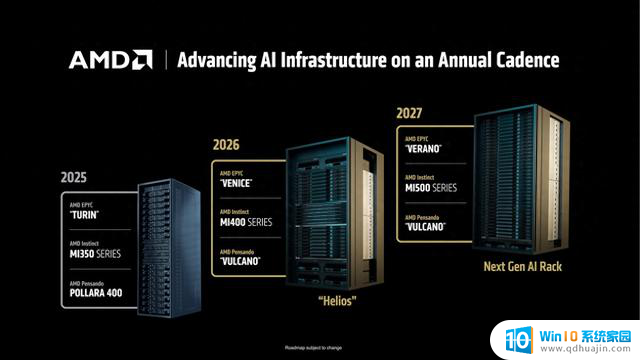

NVIDIA Grace Blackwell 机架式解决方案和 NVIDIA Grace Blackwell Ultra 机架式解决方案是机架级液冷系统,专为要求严苛的任务而设计。比如处理具有数万亿参数的大语言模型推理。它们的架构还针对测试时扩展的精度和性能进行了专门优化,使其成为运行 AI 推理模型的理想选择,同时还能有效地管理能源成本和散热问题。

液冷 NVIDIA Blackwell 计算托盘

推动 AI 数据中心实现前所未有的用水效率提升和成本节约

过去,仅散热冷却一项就占数据中心用电量的 40%,这使其成为了提高能效、降低运营成本和能源需求的关键因素之一。

液冷技术通过直接在热源处吸收热量,有助于降低成本和能耗。直接芯片(direct-to-chip)的液冷技术不再依赖空气作为散热媒介,而是通过技术冷却系统回路传递热量。这些热量随后通过液对液热交换的液冷式换热器而循环到冷却液分配单元,最终转移到设施冷却回路中。由于这种热传递的效率更高,数据中心和 AI 工厂可以在水温更高的情况下有效地运行,从而在许多气候条件下可以减少甚至无需使用机械冷水机组。

NVIDIA Grace Blackwell 机架式解决方案机架级液冷系统基于 NVIDIA Blackwell 平台构建,在平衡能源成本和散热的同时,可提供卓越的性能。它将每个服务器机架的计算密度提升到了前所未有的高度,与传统风冷架构相比,其营收潜力提高了 40 倍,吞吐量提高了 30 倍,能效提高了 25 倍,用水效率提高了 300 倍。对于基于 NVIDIA Blackwell Ultra 平台构建的 NVIDIA Grace Blackwell Ultra 机架式解决方案,其营收潜力更是提高了 50 倍,吞吐量提高了 35 倍,能效提高了 30 倍。

据 CBRE 的一份报告,数据中心的年度支出大约为每兆瓦 190 万至 280 万美元,其中近 50 万美元用于散热相关的能源和水资源成本。通过部署液冷 NVIDIA Grace Blackwell 机架式解决方案,超大规模数据中心和 AI 工厂的成本可降至传统方案的 1/25。对于一个 50 兆瓦的超大规模数据中心来说,每年可节约超过 400 万美元。

对于数据中心和 AI 工厂运营商而言,这意味着更低的运营成本、更高的能效指标,以及面向未来的基础设施,从而能够高效地扩展 AI 工作负载,同时避免传统散热方法不可持续的水资源消耗问题。

将热量排出数据中心

随着计算密度上升以及 AI 工作负载产生前所未有的热量负荷,数据中心和 AI 工厂必须重新思考如何从基础设施中排出热量。传统散热方法适用于可预测的 CPU 扩展方案,但已经无法独立地满足这种需求。如今,已有多种方法可以将热量排出设施,但当前和新兴的部署方案主要采用了以下四大类方法。

主要散热方法

这些方法各有优势,选择时需考虑气候、机架密度、设施设计和可持续发展目标等因素。随着液冷技术的普及以及服务器设计能够适应更高水温,更高效、更环保的冷却方案将逐渐变得可行,即在提升计算性能的同时还能降低能耗和用水量。

优化面向 AI 基础设施的数据中心

随着 AI 工作负载呈指数级增长,运营商们正在重新设计数据中心,构建专为高性能 AI 和能效打造的基础设施。无论是将整个设施转变为专用 AI 工厂,还是升级模块化组件,优化推理性能对于控制成本和提高运营效率来说都至关重要。

为了实现最佳性能,仅配备高算力 GPU 是不够的,这些 GPU 还需要能够极速地相互通信。

NVIDIA NVLink 增强了 GPU 之间的通信,使它们能够作为一个紧密集成的大规模处理单元运行,在 120 千瓦的全机架功率密度下实现最高性能。这种紧密的高速通信对今天的 AI 任务至关重要,因为数据传输每节省一秒都意味着更高的每秒 token 量和更高效的 AI 模型。

传统风冷方案难以应对如此高的功率。为了满足散热需求,数据中心的空气需要冷却至冰点以下或以接近暴风的速度流动才能带走热量,这使得仅靠空气来冷却高密度机架变得越来越不切实际。

液冷的密度几乎是风冷的 1000 倍,而且拥有卓越的热容和热导率,这使得液冷在散热方面表现出色。通过有效地带走高性能 GPU 产生的热量,液冷减少了对噪音大、能耗高的冷却风扇的依赖,从而可将更多电力用于计算,而非散热。

液冷技术的实际应用

整个行业的创新者都正在利用液冷技术降低能源成本、提高密度并提升 AI 能效:

云服务提供商也正在积极地采用最先进的冷却和电力创新技术。下一代 AWS 数据中心采用联合开发的液冷解决方案,在保持用水效率的同时,其算力提高了 12%,能耗最多降低至原来的 46%。

为未来的 AI 基础设施散热

随着 AI 不断突破计算规模的极限,冷却技术的创新对于应对后摩尔定律时代的热管理挑战至关重要。

通过 COOLERCHIPS 等项目,NVIDIA 正在引领这场变革。COOLERCHIPS 项目致力于开发配备下一代散热系统的模块化数据中心,与传统风冷设计相比,其成本预计至少降低 5%,能效提高 20%。

展望未来,数据中心必须以可持续的方式满足 AI 不断增长的需求,在最大限度地提高能源和用水效率的同时,尽可能减少对环境的影响。通过采用高密度架构和先进的液冷技术,行业正在为未来更高效的 AI 发展铺平道路。

点击链接,了解加速计算如何通过 NVIDIA Blackwell 平台开创更环保的未来:https://m.nvidia.cn/data-center/technologies/blackwell-architecture/?sessionid=